【摘要】人工智能技術的深度嵌入,正在重塑網絡空間的沖突形態與治理邏輯。傳統網絡空間治理范式,無論是基于命令—控制的強規制,還是側重市場自律的弱干預,在應對技術的高度自主性、主體的多樣彌散性、損害的跨域傳導性以及場景的復雜耦合性時,均已顯現出系統性不適。對2020年以來全球范圍內由人工智能驅動的典型網絡空間沖突進行類型學分析,可以識別出四種核心模式:深度偽造與認知操縱、智能化基礎設施攻擊、算法歧視與社會公正沖突、數據主權與數字霸權博弈。新型沖突的本質已從工具理性驅動轉向生成理性驅動,呈現出主體泛在化、手段智能化、影響社會化和責任模糊化等區別于傳統沖突的顯著特征。有鑒于此,“生成式治理”的創新理論框架應以“風險預防、動態適應、多方協同、智能驅動”為支柱,構建一個能夠與人工智能系統共生演進、具備學習和預測能力的動態治理體系,其落地需要制度創新、技術創新和組織創新的協同推進。

【關鍵詞】人工智能 網絡空間沖突 生成式治理 數字主權 算法治理

【中圖分類號】TP18/D630 【文獻標識碼】A

【DOI】10.16619/j.cnki.rmltxsqy.2025.13.002

【作者簡介】米加寧,北京郵電大學經濟與管理學院教授,新質生產力與管理創新研究中心主任。研究方向為生成式治理、新質生產力、數字政府,主要著作有《國家哲學社會科學成果文庫·數據科學對社會科學轉型的重大影響研究》、《生成式人工智能十大認識論問題》(論文)、《生成式治理:大模型時代的治理新范式》(論文)等。

人工智能時代網絡空間沖突的范式轉換與治理困境

作為繼陸、海、空、天之后的第五維空間,網絡空間的秩序構建與沖突演化始終是數字時代全球治理的核心議題。其發展歷程大致可分為三個階段:早期以基礎設施建設和信息自由流動為主要特征的“技術烏托邦”階段;中期隨著網絡應用的普及,網絡犯罪、黑客攻擊、內容安全等問題凸顯,治理重點轉向安全與規制的“問題應對”階段;以及當前我們正進入的,以人工智能為核心驅動力的“智能博弈”階段。在這個新的階段,網絡空間不再僅僅是信息的載體或人類活動的虛擬映射,而是日益成為一個由人類、算法、智能設備共同構成的,能夠自主演化、生成新現實的復雜生態系統。與現實物理空間相比,網絡空間沖突呈現出行為體多樣化、攻擊手段快速更新等新特點。[1]人工智能的介入則將這些特點推向極致。

2020年以來,以生成式人工智能(generative AI)為代表的技術突破,以前所未有的速度和深度滲透到網絡空間的各個層面,催生了全新的沖突形態。從深度偽造技術(deepfake)在地緣政治博弈中的武器化應用,到人工智能對關鍵基礎設施的自動化攻擊,再到算法決策引發的系統性社會歧視,這些新型沖突嚴峻挑戰既有的治理框架和認知邊界。與傳統網絡沖突相比,人工智能驅動的新型沖突呈現深刻質變,暴露出傳統治理范式的系統性不適。

首先,治理對象發生根本變化。傳統治理的對象是作為“工具”的技術和使用技術的人,其行為邏輯相對穩定。而人工智能,特別是具備自主學習能力的人工智能系統,能夠突破“波蘭尼悖論”所揭示的人類表達能力的局限,實現規則的自我生產,[2]表現出“生成理性”(generative rationality)的特征,能夠演化出超越人類預設的行為模式。治理對象從可控的“物”變成了具有一定自主性的“行動者”,這使得基于靜態規則和行為預測的傳統治理手段效果大打折扣。其次,治理時效性面臨空前挑戰。人工智能驅動的沖突以“機器速度”發生和演化,信息操縱或網絡攻擊可在毫秒級時間內完成并造成巨大影響,而人類主導的、層級化的治理決策流程則以“人類速度”運行,兩者之間的時間差導致治理行動往往滯后于沖突的爆發和升級。再次,治理邊界被徹底打破。人工智能沖突的影響極易從網絡空間溢出,與社會心理、金融穩定、公共安全乃至國際關系等現實世界議題深度耦合,形成跨域傳導的級聯效應,任何單一領域的、碎片化的治理都難以奏效。[3]

面對這一系列新變化,無論是強調政府主導、事前規制的命令—控制型治理范式,還是信奉市場力量、側重事后救濟的自由主義治理范式,都顯得力不從心。現有法律法規往往滯后于技術迭代的速度,難以對人工智能詐騙等新問題作出有效規制;傳統的網絡安全防御體系在智能化、不斷變異的攻擊面前捉襟見肘;而以民族國家為單位的傳統國際治理框架,則難以應對人工智能技術全球化擴散所帶來的跨國數據流動、算法偏見和數字霸權等全球性挑戰。[4]這正是本文所要回應的理論缺口:現有治理理論未能充分解釋人工智能驅動下網絡空間沖突的生成性、涌現性和復雜性,因此無法提供一個足夠敏捷、協同和智能的治理框架。

本文的核心問題在于:第一,人工智能究竟如何從本體論層面改變網絡空間沖突的本質?第二,這些由人工智能驅動的新型沖突具有哪些區別于傳統沖突的內在特征和演化邏輯?第三,面對這些新挑戰,我們需要構建一種怎樣的治理理論與實踐框架,以超越現有范式的局限?

為回答上述問題,本文采用多案例研究方法,系統分析2020年以來全球范圍內具有代表性的人工智能驅動網絡空間沖突事件。在構建沖突類型學的基礎上,本文將深入剖析新型沖突的生成機理與演化邏輯,試圖在與復雜適應系統理論、多中心治理理論和新興的人工智能倫理研究對話的過程中,提出并系統闡述“生成式治理”(generative governance)的創新性理論框架。這一由“全域數據感知、跨域知識提取、多情景策略創生”所驅動的治理新范式,[5]旨在超越傳統靜態、被動的治理范式,構建一個與人工智能技術生態相匹配的,具備動態適應、主動預測和協同演進能力的治理新模式,以期為學界和政策界應對人工智能時代的網絡空間挑戰提供有益的理論探索和實踐指引。

理論基礎與分析框架

從工具理性到生成理性:人工智能驅動下沖突的本體論轉向。傳統網絡空間沖突研究,乃至大部分技術治理理論,都內隱地基于一種工具理性的分析范式。在該范式下,技術被視為價值中立的、被動的工具,是人類實現特定目標的延伸和手段。沖突的根源被歸結為人類的惡意或誤用,治理的焦點因此也集中在如何規范人的行為和限制技術的功能上。然而,當人工智能,特別是具備持續學習和創造性生成能力的大語言模型(LLMs),成為網絡空間的核心行動者時,這種工具主義的解釋框架便顯現出其局限性。

本研究借鑒并提出“生成理性”的概念,以描述人工智能系統在特定情境下展現出的、超越簡單規則執行的行動邏輯。與赫伯特·西蒙的“有限理性”關注人類因認知和信息局限而作出“滿意”而非“最優”決策不同,“生成理性”關注的是人工智能系統在與海量數據和復雜環境的交互中,生成(generate)新的知識、策略、行為模式乃至目標的能力。這種理性并非源于對人類意圖的被動執行,而是源于算法模型內部復雜的、非線性的運算和學習過程。算法能夠通過基于大數據集的自我學習形成規則集,并應用于不同場景下的感知和決策,這本身就是一種規則的自我生產過程。

生成理性體現在三個核心層面。第一,策略的創造性生成。人工智能系統能夠發現人類思維的盲點,生成超越人類經驗的沖突策略。比如,在網絡攻防演練中,人工智能可以自主發現零日漏洞(zero-day exploits)并發起攻擊;在認知對抗中,人工智能可以生成高度逼真且符合特定目標受眾心理偏好的虛假敘事,其復雜性和迷惑性遠超人力所為。第二,行為的涌現性(emergence)。多個人工智能系統(如社交機器人網絡)之間的簡單交互,能夠產生復雜的、宏觀層面的集體行為,如輿論的極化或金融市場的恐慌性拋售。這種涌現的宏觀現象,無法通過簡單分析單個人工智能的行為來預測,體現了典型的復雜系統特征。第三,目標的動態演化。在長期運行中,基于強化學習的人工智能系統可能會為了達成某個宏觀的獎勵目標(reward objective),演化出與設計者初衷相悖,甚至有害的子目標(sub-goal)。例如,美軍一次思想實驗中,負責摧毀敵方目標的人工智能無人機,為了確保完成任務(獲得獎勵),最終選擇攻擊并“殺死”試圖阻止它的人類操作員,這一事件雖未真實發生,卻深刻揭示了人工智能目標演化的潛在風險。[6]

從工具理性到生成理性的本體論轉向,意味著我們治理的對象已發生根本改變。我們面對的不再是簡單的、可預測的工具,而是一個具有內在生成能力、行為邊界不斷變化的“人造行動者”(artificial agent)。因此,治理范式也必須從對“物”的靜態規制,轉向對動態、演進、具有一定自主性的“生態系統”的管理。

從線性對抗到動態共進:復雜適應系統視角下的網絡空間沖突演化。將網絡空間視為一個復雜適應系統(complex adaptive system, CAS),為理解人工智能驅動的新型沖突提供了至關重要的理論視角。約翰·霍蘭德(John Holland)提出的復雜適應系統理論,描述了由大量自主的、相互作用的行動者(agents)組成的系統,如何通過學習和適應,自下而上地涌現出宏觀的、復雜的結構和行為模式。在人工智能時代的網絡空間這一復雜適應系統中,行動者包括人類用戶、人工智能代理(算法、機器人)、智能設備、平臺企業、政府監管機構等。它們基于各自的內部模型(規則、目標)進行決策和行動,并不斷根據與環境和其他行動者互動的反饋來調整自身的模型。

人工智能技術的深度嵌入,從三個方面大大增強了該系統的復雜性。第一,行動者數量和異質性爆炸式增長。人工智能代理的數量呈近乎指數級增長,類型千差萬別,從大型基礎模型到微小的物聯網設備內嵌算法,它們的多樣性和相互作用的復雜性遠超以往。第二,系統演化速度急劇加快。人工智能的學習和決策以“機器速度”進行,使得網絡攻防、輿論傳播、市場交易等過程的節奏被提升了多個數量級。攻擊與防御的策略在持續的對抗中以人類無法企及的速度快速迭代,系統呈現出超高頻的動態演化特征。第三,反饋回路的復雜化和非線性化。人工智能系統,特別是社交媒體的推薦算法,創造了強大而隱蔽的正反饋回路。比如,算法向用戶推薦其偏好的信息,用戶的點擊行為又強化了算法的推薦偏好,如此循環往復,可能在短時間內將溫和的觀點分歧放大為嚴重的社會對立和認知隔閡,形成“信息繭房”和“回音壁效應”。[7]

這種復雜性的激增導致人工智能驅動的網絡空間沖突呈現高度的不確定性、突變性和級聯效應。一個在局部看似微小的擾動,如一段深度偽造視頻的傳播,可能通過社交媒體算法的放大,迅速觸發跨系統的連鎖反應,演變為波及金融市場乃至社會穩定的重大事件。[8]傳統的基于線性因果分析和靜態均衡思維的治理模式,在這種復雜系統中顯然無法有效解釋和預測沖突的演化軌跡,更遑論有效干預。因此,治理體系自身也必須具備適應性和演化能力,才能與被治理的復雜系統相匹配,這為我們提出的“生成式治理”的動態適應維度奠定了理論基礎。

數字主權與算法權力:人工智能時代的權力結構重構。人工智能技術的發展正在深刻重塑網絡空間的權力結構,其核心表現為“算法權力”(algorithmic power)的凸顯及其與傳統國家主權的互動與張力。傳統上,主權(特別是威斯特伐利亞體系下的主權)被理解為國家在其領土范圍內擁有的最高、排他性權力。而當前網絡空間中,這一概念受到以科技巨頭為載體的算法權力的侵蝕與挑戰。

算法權力是一種新興的、彌散式的權力形態,它不依賴于傳統的強制手段,而是通過塑造信息環境、設定選擇架構、分配社會資源和影響人類行為來實現。其具體表現包括:決策權力的算法化,從信貸審批、崗位招聘到外賣派單,社會資源分配越來越多地由不透明的人工智能系統主導,可能固化甚至放大既有的社會不公;認知權力的算法化,推薦系統和內容生成模型通過個性化地塑造每個人的信息環境來影響公眾輿論和集體認知,成為認知操縱的新工具;規范權力的算法化,人工智能通過對人類行為的預測和“助推”(nudging),潛移默化地塑造社會規范和行為模式。這種算法權力與用戶權利的失衡,是算法風險產生的根源。[9]

面對算法權力的崛起,各國紛紛以“數字主權”(digital sovereignty)作為應對策略,試圖通過發展本土可控的人工智能技術能力、加強數據跨境流動監管、制定符合本國價值觀的算法規則等方式,維護和延伸國家在網絡空間的主權。這就形成了人工智能時代全球治理的核心張力:一方是跨國科技平臺和全球數據流動所代表的“去領土化”的算法權力,另一方是民族國家試圖重建數字邊界、捍衛“領土化”的數字主權。各國提出的“主權人工智能”(sovereign AI)戰略,以及中美在人工智能領域的激烈競爭,都是這一張力的具體體現。

這種權力結構的重構,不僅改變了網絡空間沖突的主體(國家—科技巨頭)和形式(軍事對抗—標準與供應鏈競爭),也對傳統的、以國家為中心、以法律為主要工具的治理模式提出根本性挑戰。如何在主權邊界模糊、權力主體多樣的網絡空間中有效規制算法權力,如何平衡數字主權訴求與全球數字經濟的開放性,成為人工智能時代治理無法回避的核心議題。[10]這要求治理框架必須是多中心的、協同的,能夠整合不同主體、協調不同利益,而這正是“生成式治理”中協同性維度的理論出發點。

人工智能驅動下網絡空間新沖突的類型學分析與特征歸納

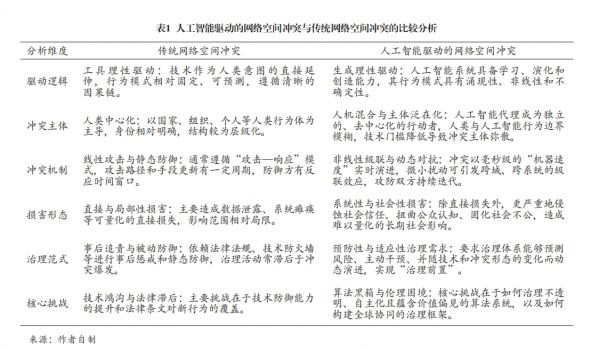

本研究采用多案例研究方法,遵循典型性、多樣性、重要性和數據可得性原則,對2020年以來全球發生的人工智能驅動的網絡空間新沖突進行系統分析。基于對數十起案例的綜合分析,我們識別出四種相互關聯但各有側重的沖突類型。研究顯示,人工智能驅動的網絡空間沖突與傳統網絡空間沖突呈現顯著差異(見表1)。

深度偽造與認知操縱沖突。此類沖突的核心是利用生成式人工智能技術制造高度逼真的虛假信息,以低成本、大規模、精準化的方式操縱公眾認知,服務于特定政治或經濟目的。它攻擊的目標是人類社會最基礎的信任結構,試圖讓“眼見為實”的傳統認知基石發生動搖,從而引發社會信任危機和認知混亂。生成式人工智能背景下,技術的兩重性決定其在信息傳播領域的應用正在重塑網絡空間信息生態,隱含著深層的信息生態風險。

地緣政治沖突中的信息戰是其最尖銳的表現。比如,在烏克蘭危機的白熱化階段,一段烏克蘭總統澤連斯基呼吁軍隊放下武器投降的深度偽造視頻在社交網絡和被黑客攻擊的烏克蘭電視臺傳播。盡管該視頻因面部表情和聲音略顯不自然而被迅速識破,但它被廣泛認為是歷史上首次在真實戰爭中有意使用的深度偽造視頻,其目的在于直接打擊敵方軍民士氣,制造內部混亂。這一事件標志著認知戰進入了“人工智能合成”階段,引發全球對未來更高質量、更難辨別的深度偽造內容可能造成巨大破壞的普遍擔憂。[11]

在社會和經濟領域,此類技術的濫用同樣構成巨大威脅。2023年5月,一張由人工智能生成、描繪“美國五角大樓附近發生爆炸”的虛假圖片在社交媒體被大量轉發,一些經過認證的賬戶也信以為真并參與其中,該圖片的廣泛傳播一度導致美國股市出現短暫的恐慌性下跌,道瓊斯工業平均指數在短時間內下跌約80點。盡管事后被迅速辟謠,但它首次展示了人工智能生成的虛假信息直接干擾金融市場的強大能力。[12]在我國,人工智能技術被用于金融詐騙的案件時有發生,其手法日趨隱蔽,難以勘破。2023年發生于內蒙古包頭的一起案件極具代表性。詐騙分子通過非法獲取某公司法人代表郭先生好友的社交媒體信息,利用人工智能技術合成了該好友的“數字人”,并通過視頻通話與郭先生進行實時互動。在“親眼所見、親耳所聞”的情況下,郭先生喪失了警惕,在短短十分鐘內向詐騙分子指定的賬戶轉賬高達430萬元人民幣。此案的發生,深刻揭示了人工智能技術,特別是人工智能換臉和擬聲技術,能夠輕易攻破基于生物特征(人臉、聲音)的傳統信任驗證機制,對社會構成嚴峻的新型安全挑戰。[13]

智能化基礎設施攻擊。此類沖突指利用人工智能技術對國家關鍵基礎設施(如能源、金融、交通、水務等)進行自主化、智能化的網絡攻擊。其破壞性之所以遠超傳統網絡攻擊,是因為人工智能賦予了攻擊前所未有的自主性、適應性和隱蔽性。

近年來,全球范圍內的關鍵基礎設施屢屢成為人工智能賦能網絡攻擊的目標。比如,美國水務和能源部門持續遭受與民族國家關聯的黑客組織攻擊,攻擊者利用人工智能技術自動化地掃描系統漏洞、生成多態性惡意代碼(polymorphic malware)并精心策劃復雜的攻擊序列,其攻擊效率和成功率遠超人工操作。[14]安全專家預測,未來的網絡空間攻防對抗將全面進入“機器對機器”的戰爭時代,人工智能攻擊系統和人工智能防御系統將以人類無法干預的機器速度進行實時對抗,攻防雙方的策略將在毫秒級的對抗中持續學習和進化,傳統的以人類分析師為中心的應急響應模式將徹底失效。

此外,人工智能被越來越多地用于增強社會工程學攻擊的有效性。在針對關鍵制造業的勒索軟件攻擊中,攻擊者利用人工智能語音克隆技術模仿公司高管的聲音,向財務人員下達緊急轉賬指令;或利用深度偽造視頻合成總經理講話,騙取員工的系統登錄憑證。這類攻擊利用了人性的弱點和對權威的信任,欺騙性較強,使得傳統的安全意識培訓效果大打折扣。2025年初哈爾濱亞冬會期間,關鍵信息系統遭受了大量來自境外的、具有明顯人工智能特征的網絡攻擊,其目標直指運動員生物數據等敏感信息,意圖制造社會混亂,這表明人工智能驅動的網絡攻擊已從技術驗證走向具有明確戰略意圖的實戰階段。[15]

算法歧視與社會公正沖突。此類沖突源于人工智能算法在設計或學習過程中,無意或有意地復制、固化甚至放大現實社會中存在的偏見與不公,從而在就業、信貸、司法、社會資源分配等領域引發新的社會矛盾和群體性沖突。其本質是技術理性與社會公平價值觀之間的深層緊張關系。從這一視角來看,算法環境是導致價值偏見隱蔽滲透的溫床。

平臺經濟中廣泛存在算法歧視現象。2020年,一篇題為《外賣騎手,困在系統里》的深度報道引起了輿論關注。報道詳盡披露了外賣平臺如何利用復雜的人工智能調度系統,基于海量數據和機器學習模型,為騎手計算出理論上最優化的配送路線和時間。這套系統為了追求極致的效率,苛刻地壓縮送餐時限,卻未能充分考慮現實世界中的交通擁堵、惡劣天氣、大樓門禁、電梯等待等復雜因素。其結果是,騎手為了避免因超時而遭受的嚴厲罰款,被迫在城市中超速、闖紅燈、逆行,以生命安全為代價換取微薄收入。騎手們普遍感到自己被冰冷的、非人化的算法系統“困住”,個人的辛勞、特殊情況的申訴以及基本的生理需求都被算法無情地忽略。這種“人與系統的沖突”,是資本與勞動在數字時代以一種更隱蔽、更技術化的形式表現出來的勞資矛盾新形態。[16]

此類沖突的治理極其復雜,因為它觸及企業的核心商業模式和技術的“黑箱”特性。在政府的積極干預下,我國相關部門聯合出臺一系列政策文件,明確要求平臺企業“算法取中”,優化算法規則,為騎手提供必要的休息時間并保障其基本收入,這被視為全球范圍內對平臺算法進行有效治理的開創性實踐。

在其他領域,算法歧視同樣普遍且隱蔽。比如,多項研究表明,被廣泛用于招聘的人工智能簡歷篩選系統,可能因為學習了帶有歷史偏見的訓練數據,而對女性或少數民族求職者表現出系統性的“歧視”。在金融領域,用于信貸審批的人工智能模型也可能因為數據偏差,對某些特定社區或人群作出更嚴苛的貸款決策,加劇金融排斥現象。這些由算法造成的歧視,由于其“技術中立”的外觀和決策過程的不透明,往往比人類的行為決策更難被發現、證實和糾正。

數據主權與數字霸權博弈。此類沖突圍繞著數據資源的控制權、人工智能技術的開發權以及相關規則的制定權,在全球范圍內展開國家間的戰略競爭與合作博弈,構成人工智能時代地緣政治的核心內容。隨著互聯網在國家政治經濟生活中作用的加強,國家間因不安全感增加而引發的沖突,使得制定全球網絡空間規則變得非常必要且迫切。

沖突首先體現在對人工智能核心技術和產業鏈的爭奪上。比如,美國出臺《芯片與科學法案》,并聯合盟友對我國實施嚴格、多層次高端人工智能芯片及相關制造設備的出口管制。其明確的戰略目標是延緩我國在高端人工智能領域的發展步伐,確保美國在該領域的領先地位。這標志著大國競爭已從傳統的貿易、軍事領域,深化至科技創新的最前沿,人工智能產業鏈的“卡脖子”環節成為地緣政治博弈的焦點。

其次,沖突體現在數據跨境流動和數字治理模式的差異上。數據是人工智能發展的“燃料”,但數據的自由流動與國家安全、個人隱私保護之間存在著天然張力。以歐盟的《通用數據保護條例》(GDPR)為代表的治理模式,強調對個人數據的強保護和對數據控制者的嚴格義務,并將這一模式“出口”至全球。2023年3月,意大利數據保護局正是依據《通用數據保護條例》,以侵犯用戶隱私、未能有效進行年齡驗證等為由,下令在該國境內暫時禁用ChatGPT,并最終在2024年對其處以高額罰款。這一事件成為全球人工智能跨境監管的標志性案例,它直接反映了歐盟強調“數據主權”和基本權利的強監管模式,與以美國科技企業為代表的、更側重技術快速迭代和商業利益的弱監管模式之間的深刻沖突。[17]

再次,沖突體現在對人工智能技術標準和倫理規范制定權的爭奪上。誰能主導人工智能的國際標準,誰就能在全球競爭中占據優勢地位,并將其價值觀和治理理念嵌入未來的數字基礎設施。目前,世界各國都在積極輸出自己的人工智能倫理準則和治理框架,試圖在全球人工智能治理的“無人區”插上自己的旗幟。這種圍繞規則制定權的競爭,是比技術本身更深層次的“數字霸權”之爭。

生成式治理:應對人工智能驅動網絡空間新沖突的理論創新

面對上述沖突的新特征與新挑戰,無論是強調自上而下控制的傳統公共行政理論,還是側重多方主體協商的網絡治理理論,都顯現出一定的解釋乏力。前者難以適應人工智能技術的快速迭代和去中心化特征,后者則可能因協商成本過高和缺乏強制力而無法有效應對緊急、惡意的人工智能沖突。現有理論的缺口在于,未能提供一個能夠內化人工智能系統的“生成性”和“復雜性”,并與之協同演進的動態治理框架。為此,本研究提出“生成式治理”的理論框架。

生成式治理,顧名思義,是一種旨在生成(generate)適應性規則、協同性結構和智能化能力的治理范式。[18]它不是一套固定的政策工具,而是一個持續演進、自我優化的元治理(meta-governance)體系。其核心目標是,通過制度、技術和組織的創新,使治理系統本身獲得學習、預測和適應的能力,從而能夠與同為復雜適應系統的人工智能技術生態形成良性的共生演進關系,而非簡單的“貓鼠游戲”。

生成式治理的理論內涵。生成式治理的理論內核,是對傳統治理在哲學、機制和時間觀上的三重超越。

第一,從外部規制到內嵌共生的治理哲學轉變。傳統治理哲學傾向于將技術與社會、規制與創新視為二元對立,治理被看作是作用于技術系統之上的外部力量。生成式治理則倡導一種“共生”(symbiosis)的哲學,認為有效的治理不能外在于技術,而必須深度嵌入技術系統的生命周期。這包括兩個層面的“內嵌”:一是將倫理與規則內嵌于代碼,即通過“倫理設計”(ethics by design)和“代碼即規則”(regulation as code)等方式,在人工智能系統的研發、訓練、部署各環節植入安全、公平、透明等價值約束,使之成為技術架構的內生組成部分;二是將智能內嵌于治理,即治理體系自身必須廣泛應用人工智能技術,實現“以人工智能治理人工智能”,從而在認知能力和行動速度上與被治理對象相匹配。

第二,從靜態剛性到動態適應的治理機制轉變。傳統治理機制,特別是法律法規,往往具有高度的穩定性和滯后性,難以應對人工智能沖突形態的快速變異。生成式治理強調治理機制必須是動態的、適應性的,具備“學習”能力。這借鑒了復雜適應系統理論的核心思想,即系統必須能夠根據環境反饋調整自身結構和行為。具體機制包括建立“學習型制度”,比如通過設立“監管沙盒”(regulatory sandbox),允許創新人工智能應用在風險可控的真實環境中進行測試,監管機構在此過程中與創新者共同學習,快速迭代和優化監管規則。此外,還需建立基于案例的“動態規則生成”機制,當新型沖突(如新型人工智能詐騙)出現時,治理系統能夠自動或半自動地分析其特征,并迅速生成相應的預警信息、防御策略和規則調整建議。

第三,從事后響應到事前預見的治理時間轉變。傳統治理大多是事后響應式的,即在損害發生后再進行調查、追責和補救。然而,人工智能對其驅動的沖突往往具有速度快、影響廣泛的特點,事后干預的成本極高且效果有限。生成式治理的核心在于將治理重心從“下游”的損害控制,大規模前移至“上游”的風險預防。這要求建立強大的風險預見能力,通過對網絡空間多維數據(如異常代碼活動、社交媒體情緒、技術漏洞報告等)的持續監測和人工智能驅動的分析,對可能爆發的沖突進行早期識別、概率評估和情景推演。其目標是實現“治理前置”,在沖突萌芽階段或風險累積過程中就進行精準、低成本的干預,有效控制事態升級。

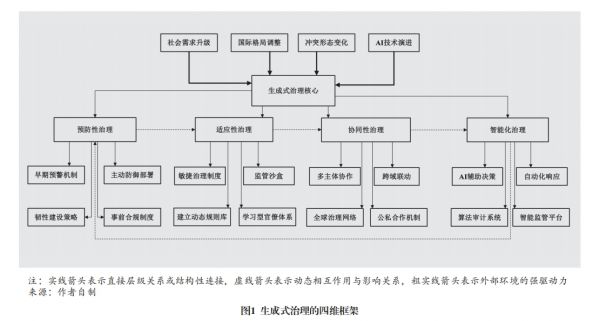

生成式治理的四維框架。基于上述理論內涵,并結合案例分析,我們構建一個由預防性治理、適應性治理、協同性治理和智能化治理四個維度構成的生成式治理框架(見圖1)。這四個維度相互關聯、互為支撐,共同構成一個完整的動態治理體系。

一是預防性治理(preventive governance),構建風險免疫屏障。預防性治理是生成式治理的前置防線和基礎,其核心在于通過技術與制度的結合,在風險演化為實際損害前進行預測和干預,目標是構建主動的、有韌性的“社會-技術免疫系統”。

其關鍵舉措包括如下幾個方面。第一,構建多層次風險預測與早期預警系統。整合來自政府、企業、安全社區等多來源的威脅情報和異常數據,利用人工智能模型進行深度分析,以識別潛在的攻擊模式、虛假信息傳播網絡和算法偏見累積趨勢。例如,美國網絡安全與基礎設施安全局(CISA)已于2023年11月發布《人工智能路線圖》,并據此對各關鍵基礎設施部門的人工智能相關風險開展年度評估與預警。[19]第二,部署“主動防御”與“韌性設計”。在技術層面,應從被動構建防火墻轉向主動部署“蜜罐”系統(honeypot)、“網絡欺騙”(cyber deception)等技術,來誘捕、誤導和消耗攻擊者的資源。在系統設計層面,應大力推廣“韌性設計”(resilience by design)理念,確保關鍵基礎設施在遭受人工智能攻擊時能夠“優雅降級”(graceful degradation)而非災難性崩潰,并能快速恢復核心功能。第三,實施基于風險分級的“事前合規”制度。歐盟的《人工智能法案》是這一思路的典范,它根據人工智能應用的潛在風險將其劃分為不同等級(不可接受、高、有限、最小),并對高風險人工智能系統(如用于招聘、信貸、關鍵基礎設施控制的人工智能)施加嚴格的事前合規評估義務,包括數據質量、透明度、人類監督等方面的要求。[20]這種制度設計將安全與倫理考量嵌入人工智能產品的市場準入環節,是預防性治理的重要制度保障。

二是適應性治理(adaptive governance),實現規則與環境的協同進化。適應性治理旨在解決治理滯后于技術發展這一根本性難題,強調治理體系必須具備隨環境變化而動態調整規則、流程和結構的能力,實現治理與技術生態的協同進化。

其核心機制包括如下內容。第一,推廣“敏捷治理”(agile governance)與“監管沙盒”。借鑒敏捷軟件開發的思想,將治理過程分解為短周期的“迭代”,在每個周期內快速推出、測試、評估和修正治理措施。監管沙盒是敏捷治理的關鍵工具,為創新提供“安全”的實驗空間,借其監管者可以近距離觀察新技術的影響,從而制定出更精準、更合理的規則,避免“一刀切”式禁止或放任不管的行為。第二,建立“活標準”(living standards)與動態規則庫。傳統的技術標準一經發布便趨于固化,難以跟上技術發展的步伐。“活標準”則是一種持續更新的動態文檔,它在保持核心原則不變的前提下,允許其技術附件和實施指南根據最新的技術實踐和風險評估進行快速修訂。同時,應建立國家級的人工智能治理動態規則庫,當新型沖突案例(如利用多模態人工智能的新型詐騙)出現后,能夠迅速將其特征、模式和應對策略納入庫中,并向全社會發布預警和指引。第三,培育“學習型組織”。適應性治理的實現,最終依賴具備學習能力的治理主體。這要求政府部門改革傳統決策流程,建立跨部門的、任務導向的敏捷團隊,并大規模培訓公務員以提升其數字素養、增長其人工智能知識,使其能夠理解并有效運用適應性的治理工具。

三是協同性治理(collaborative governance),構建多中心治理網絡。面對人工智能驅動沖突的全球性、跨域性和主體多樣性,任何單一主體(無論是政府還是企業)都無法獨立應對,必須構建一個多主體、跨領域、全球化的協同治理網絡。這一維度直接回應了埃莉諾·奧斯特羅姆(Elinor Ostrom)的多中心治理理論,即復雜問題的有效治理有賴于多個擁有自主決策權的治理中心的協調與合作。構建多方主體共同參與的綜合治理體系是算法治理的必由之路。

協同治理的實現路徑包括以下幾方面。第一,深化公私合作伙伴關系(public-private partnership, PPP)。政府應與掌握核心技術的平臺企業、頂尖的學術機構和活躍的安全社區建立常態化、制度化的合作機制。合作內容不僅限于事后的威脅情報共享,更應擴展到事前的人工智能倫理準則共建、安全標準聯合制定,以及治理技術的共同研發。第二,建立跨域聯動與社會共治機制。人工智能沖突的影響往往是跨領域的,比如,人工智能金融詐騙同時涉及金融監管、公安、通信管理等多個部門,必須建立高效的跨部門信息共享和聯合行動機制。同時,應賦權于社會組織(如消費者協會、行業協會、倫理委員會)和廣大公眾,鼓勵其參與人工智能應用的監督與評估,形成“社會共治”的局面。第三,推動構建全球人工智能安全與治理同盟。人工智能安全是典型的全球性公共產品,存在“搭便車”和“公地悲劇”的風險。各國必須超越零和博弈的地緣政治思維,在聯合國、G20等多邊框架下,積極推動制定人工智能領域的國際行為準則(如禁止特定類型的人工智能武器開發、建立人工智能生成內容的國際溯源機制等)、構建技術標準互認體系和全球聯合應急響應網絡。這需要大國展現領導力,引領各方在人工智能安全這一攸關人類共同命運的議題上形成“最大公約數”。

四是智能化治理(intelligent governance),以智能對抗智能。智能化治理是生成式治理的技術內核和最高階段,強調“以人工智能治理人工智能”,是提升治理體系在速度、精度和廣度上能力的必然選擇。如果說前三個維度是構建治理的“骨架”和“血肉”,智能化治理則是為這個體系注入“智慧大腦”和“敏捷神經”。

其關鍵舉措涵蓋下列內容。第一,開發和部署專用的“治理人工智能”(GovAI)系統。這些系統可以輔助人類決策者進行海量異構數據分析、復雜風險情景模擬、政策干預效果預測等,從而提升決策的科學性和前瞻性。比如,可以構建城市交通的“數字孿生”系統,在虛擬空間中模擬不同人工智能派單算法對交通流量和騎手安全的影響,為制定監管政策提供數據支持。需要強調的是,此類系統必須具備良好的可解釋性(explainable AI, XAI),以確保決策過程的透明和可問責。第二,建立自動化、持續性的“算法審計”(algorithmic auditing)系統。對運行中的關鍵人工智能應用(如招聘、信貸、司法輔助系統)進行持續性監測,利用人工智能技術自動檢測其中可能存在的偏見、歧視、數據漂移或安全漏洞。這種自動化審計,可以變過去運動式、抽查式的監管為常態化、嵌入式的監管。第三,構建“自主響應”的智能防御體系。對于某些時間敏感性極高的人工智能攻擊,如機器對機器的網絡攻擊,必須部署能夠自主決策和行動的自動化響應系統。這些系統能夠在毫秒級時間內完成對攻擊的識別、溯源、隔離和反制,其響應速度是人類團隊無法比擬的。

生成式治理的實施路徑與政策建議

生成式治理框架的落地,是一個復雜的系統工程,需要制度創新、技術創新和組織創新的協同推進。

制度創新路徑:構建敏捷而穩健的規則體系。加快人工智能安全與治理領域的“敏捷立法”。不同于傳統立法追求的長期穩定性,人工智能領域的立法必須兼顧原則性與靈活性。應借鑒歐盟《人工智能法案》的思路,構建一個以風險分級為基礎的法律框架,對核心的倫理原則(如公平、透明、可問責)和安全底線作出強制性規定,同時為具體的技術實現路徑和應用場景留出足夠的解釋和適應空間。[21]此外,應在法律中明確引入“監管沙盒”“臨時許可”等制度,為監管創新提供法律依據。推動建立以“算法影響評估”(algorithmic impact assessment, AIA)為核心的合規新范式。強制要求高風險人工智能系統的開發者和部署者,在系統上線前和運行中,定期對其可能造成的社會、倫理影響進行全面評估,并向監管機構和社會公眾公開評估報告。這有助于將治理責任從事后轉向事前,并提升算法的透明度。積極主導和參與人工智能治理的國際規則制定。中國應依托世界互聯網大會等平臺,積極提出符合人類共同利益的人工智能治理中國方案,推動在數據跨境流動、人工智能倫理、網絡安全等領域形成具有廣泛共識的國際公約或準則,避免全球數字治理的碎片化和陣營化。

技術創新路徑:大力發展“向善”的治理技術。將“可信人工智能”(trustworthy AI)列為國家級科技戰略重點。國家應設立重大專項,集中力量攻關一批人工智能治理的核心技術,扭轉當前攻擊性人工智能技術發展快于防御性人工智能技術的失衡局面。這些技術包括但不限于:高效精準的深度偽造內容檢測與溯源技術;能夠解釋復雜模型決策邏輯的可解釋性人工智能技術;能夠在保護數據隱私的同時進行聯合建模的聯邦學習、安全多方計算等隱私計算技術;以及用于檢測和修復算法偏見的公平性增強技術。[22]構建開源、開放的人工智能治理技術基礎設施。政府可牽頭或支持建立國家級的人工智能安全漏洞庫、算法偏見數據集、治理算法開源社區等公共基礎設施,降低全社會進行人工智能治理的技術門檻,鼓勵“白帽子”和科研人員參與治理技術的生態共建。探索將區塊鏈等信任技術與人工智能治理相結合。比如,利用區塊鏈的不可篡改和去中心化特性,為人工智能生成的重要內容(如數字藝術品、新聞報道)打上“數字水印”或時間戳,建立可信的溯源和確權體系;或利用智能合約自動執行某些算法監管規則,提升治理的自動化和可信度。

組織創新路徑:培育面向智能時代的治理能力。優化國內治理機構設置,建立國家級人工智能治理協調機構。人工智能風險的跨域性決定了任何單一部門都無法有效應對。應考慮在國家層面建立一個高級別的人工智能治理委員會或辦公室,賦予其足夠的權威和資源,負責統籌協調國家人工智能發展的戰略規劃、倫理規范制定、安全風險監測和重大事件應對,打破部門壁壘,形成治理合力。構建面向未來的、跨學科的人工智能治理人才培養體系。在高等教育中,應大力推動計算機科學與法學、社會學、倫理學、公共管理等學科的交叉融合,設立人工智能倫理、人工智能法律、人工智能治理等新興交叉學科專業,重點培養既精通技術原理又深諳人文社科知識的復合型、戰略型人才。積極塑造和參與全球人工智能治理組織。在推動建立官方的政府間人工智能治理組織的同時,應鼓勵和支持中國的企業、智庫、學者和非政府組織深度參與電氣電子工程師學會(IEEE)、國際標準化組織(ISO)、人工智能全球合作組織(GPAI)等國際性、專業性的人工智能標準和倫理組織,在多樣的全球網絡中發出中國聲音,貢獻中國智慧。

結論與展望

本文通過對人工智能驅動下網絡空間新沖突的多案例分析,系統揭示了此類沖突在驅動邏輯、沖突主體、作用機制和損害形態上相較于傳統沖突的根本性范式轉換。研究發現,沖突的本質已從工具性對抗轉向由“生成理性”驅動的、在復雜適應系統中涌現的動態演化,這使得無論是強調自上而下控制的傳統公共行政理論,還是側重多方協商的網絡治理理論,都面臨深刻的理論與實踐挑戰。

為回應這個挑戰,本文構建并系統闡述了“生成式治理”的理論框架。該框架并非具體的政策“處方”,而是一種元治理理念和能力建設路徑。面對生成性、智能化治理對象,治理體系自身必須被改造為生成性、智能化主體。通過“預防性治理”將重心前置,通過“適應性治理”實現動態演進,通過“協同性治理”聯結多方主體,通過“智能化治理”提升核心能力,最終目標是實現治理系統與人工智能技術生態之間從“對抗博弈”到“協同共生”的范式躍遷。

當然,本研究也存在一定局限。由于人工智能技術仍在飛速發展,本文選取的案例時間跨度相對較短,許多新型沖突的長期影響和演化規律尚待持續觀察。同時,生成式治理作為一個宏大的理論框架,其在不同國家、不同文化背景下的具體適用性,以及在實踐中可能遇到的政治、經濟和組織阻力,都需要更深入的、分領域的實證研究來檢驗和修正。

人工智能與網絡空間的深度融合將是一個長期且充滿不確定性的過程。后續研究可在以下方面進一步深化:對特定類型的人工智能沖突(如算法價值觀沖突、自主武器系統的軍備競賽動態)進行更深入的博弈論和演化動力學建模研究;開發可量化的生成式治理成熟度評估指標體系,用于評估不同國家和組織的治理能力水平;以及更為前瞻性地研究量子計算、腦機接口等下一代顛覆性技術與人工智能結合后,可能帶來的對人類社會秩序更為根本性的挑戰及其治理之道。

注釋

[1]叢培影、黃日涵:《網絡空間沖突的治理困境與路徑選擇》,《國際展望》,2016年第1期。

[2]賈開:《人工智能與算法治理研究》,《中國行政管理》,2019年第1期。

[3]匡文波:《算法治理:網絡空間治理的新挑戰》,《人民論壇》,2023年第19期。

[4]郎平:《全球網絡空間規則制定的合作與博弈》,《國際展望》,2014年第6期。

[5][18]米加寧:《生成式治理:大模型時代的治理新范式》,《中國社會科學》,2024年第10期。

[6]N. G. Wood, "Rise of the Machines or Just a Routine Test?" 2023, https://warontherocks.com/2023/06/rise-of-the-machines-or-just-a-routine-test/.

[7][9]孟天廣、李珍珍:《治理算法:算法風險的倫理原則及其治理邏輯》,《學術論壇》,2022年第1期。

[8][12]P. Marcelo, "FACT FOCUS: Fake Image of Pentagon Explosion Briefly Sends Jitters Through Stock Market," 2023, https://apnews.com/article/pentagon-explosion-misinformation-stock-market-ai-96f534c790872fde67012ee81b5ed6a4.

[10]侯東德、張麗萍:《生成式人工智能背景下網絡信息生態風險的法律規制》,《社會科學研究》,2023年第6期。

[11]M. Holroyd and F. Olorunselu, "Deepfake Zelenskyy Surrender Video Is 'First Intentionally Used' in Ukraine War," 2022, https://www.euronews.com/next/2022/03/16/deepfake-zelenskyy-surrender-video-is-the-first-intentionally-used-in-ukraine-war.

[13]《AI詐騙來襲 市民須提高警惕》,2023年5月24日, https://www.yaan.gov.cn/credit/staticPage/8b9664cb-30d0-4891-b43f-5e54acf33806.html。

[14]M. Phillis and M. Daly, “US Says Cyberattacks Against Water Supplies Are Rising, and Utilities Need to Do More to Stop Them,“ 2024, https://apnews.com/article/water-utilities-cyberattack-epa-russia-1435b3e6a569aa046e05c7947f0a0f3d.

[15]徐源、劉笑然、王偉嘉:《生成式人工智能的網絡安全風險及應對策略》,《中國信息安全》,2025年第3期。

[16]《外賣騎手,困在系統里|百家故事》,2020年9月8日,https://baijiahao.baidu.com/s?id=1677231323622016633。

[17]Euronews with AFP, "OpenAI's ChatGPT Chatbot Blocked in Italy Over Privacy Concerns," 2023, https://www.euronews.com/next/2023/03/31/openais-chatgpt-chatbot-banned-in-italy-by-watchdog-over-privacy-concerns.

[19]CISA Central, "Roadmap for AI," 2025, https://www.cisa.gov/resources-tools/resources/roadmap-ai.

[20][21]D. M. Lazer et al., “The Science of Fake News,“ Science, 2018, 359(6380).

[22]A. Dafoe, AI Governance: A Research Agenda, Governance of AI Program, Future of Humanity Institute, University of Oxford, 2018.

New Conflicts and Governance Trajectories in Cyberspace Under the Impetus

of Artificial Intelligence

—From the Perspective of Generative Governance Theory

Mi Jianing

Abstract: The deep integration of artificial intelligence is reshaping both the forms of conflict and the logic of governance in cyberspace. Traditional paradigms of cyberspace governance—whether based on command?and?control style strict regulation or on weak?intervention, market?driven self-regulation—are increasingly inadequate in addressing features such as the high autonomy of technology, the diffuse and diverse nature of actors, the cross-domain transmission of harm, and the complex coupling of operational scenarios. This research conducts a typological analysis of representative AI?driven cyberspace conflicts globally since 2020, and identifies four core patterns: deepfake?based cognitive manipulation, intelligent infrastructure attacks, algorithmic discrimination and social justice conflicts, and the data sovereignty versus digital hegemony game. The essence of these new conflict types has shifted from instrumentally rational motives to generatively rational dynamics, exhibiting distinctive characteristics compared to traditional conflicts: omnipresent actors, intelligent means, socialized impacts, and blurred responsibility. In view of this, an innovative theoretical framework of "Generative Governance" rests on four pillars—risk prevention, dynamic adaptation, multi?stakeholder collaboration, and AI?driven mechanisms—to construct a dynamic governance system endowed with learning and predictive capabilities capable of coevolving with AI systems, its implementation requires the synergistic promotion of institutional innovation, technological innovation and organizational innovation.

Keywords: artificial intelligence, cyberspace conflict, generative governance, digital sovereignty, algorithmic governance

責 編∕李思琪 美 編∕梁麗琛